Von Prasad Kona

Unternehmen haben sich zunehmend auf Cloud-Daten und Cloud-Analyseplattformen wie Microsoft Azure verlegt und diese übernommen. In diesem ersten einer Reihe von Blogbeiträgen zur Azure-Datenplattform zeige ich Ihnen, wie Sie sich die Einführung von Cloud-Plattformen und die Datenintegration erleichtern können.

In diesem Beitrag konzentriere ich mich auf das Ingesting von Daten in die Azure Cloud Data Platform und zeige, wie man mit SnapLogic Daten in Microsoft Azure Storage liest und schreibt.

Für diejenigen, die gleich loslegen möchten, zeigt mein 4-minütiges Video "Aufbau einer einfachen Pipeline zum Lesen und Schreiben von Daten in Azure Blob Storage", wie Sie das Gewünschte erreichen können, ohne Code schreiben zu müssen.

Was ist Azure Storage?

Mit Azure Storage können Sie Terabytes an Daten speichern, um kleine bis große Datenanwendungen zu unterstützen. Er ist hoch skalierbar, hoch verfügbar und kann im Durchschnitt Millionen von Anfragen pro Sekunde verarbeiten. Azure Blob Storage ist einer der Dienste, die von Azure Storage angeboten werden.

Azure bietet zwei wichtige Arten von Speicher für unstrukturierte Daten: Azure Blob Storage und Azure Data Lake Store.

Azure Blob-Speicher

Azure Blob Storage speichert unstrukturierte Objektdaten. Ein Blob kann jede Art von Text- oder Binärdaten sein, z. B. ein Dokument oder eine Mediendatei. Blob Storage wird auch als Objektspeicher bezeichnet.

Azure Data Lake Speicher

Azure Data Lake Store bietet genau das, was Unternehmen heute von einem Speicher erwarten:

- Bietet zusätzliche Sicherheitsfunktionen auf Unternehmensniveau wie Verschlüsselung und verwendet Azure Active Directory für die Authentifizierung und Autorisierung.

- Ist kompatibel mit dem Hadoop Distributed File System (HDFS) und arbeitet mit dem Hadoop-Ökosystem einschließlich Azure HDInsight.

- Umfasst Azure HDInsight-Cluster, die für den direkten Zugriff auf im Data Lake Store gespeicherte Daten bereitgestellt und konfiguriert werden können.

- Ermöglicht die einfache Analyse der im Data Lake Store gespeicherten Daten mit Hadoop-Analyse-Frameworks wie MapReduce, Spark oder Hive.

Wie verschiebe ich meine Daten auf die Azure Data Platform?

Sehen wir uns an, wie Sie mit SnapLogic in Azure Data Platform lesen und schreiben können.

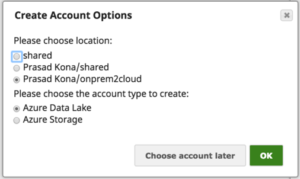

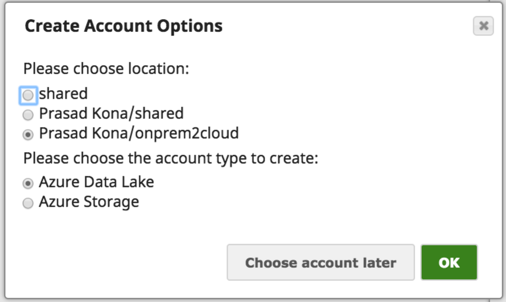

Für SnapLogic Snaps, die Azure-Konten unterstützen, haben wir die Möglichkeit, zwischen Azure Storage Account und Azure Data Lake Store zu wählen:

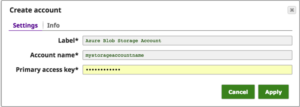

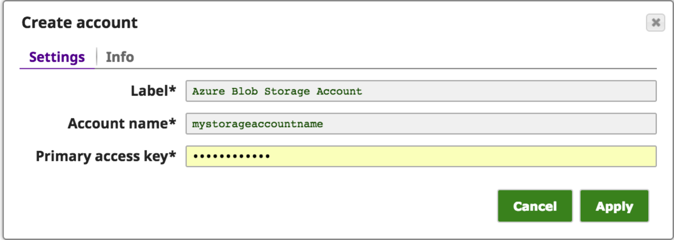

Die Konfiguration des Azure-Storage-Kontos in SnapLogic kann wie unten gezeigt unter Verwendung des Azure-Storage-Kontonamens und des Zugriffsschlüssels, den Sie vom Azure-Portal erhalten, durchgeführt werden:

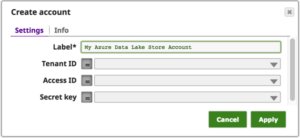

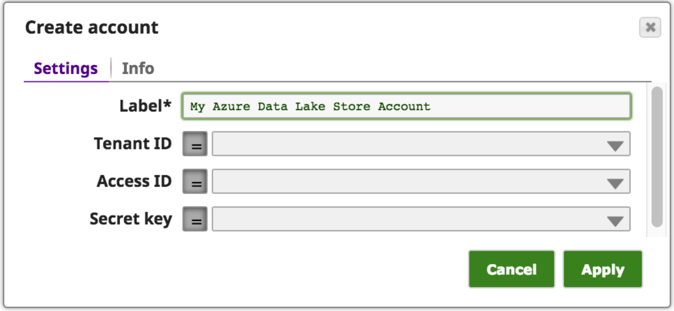

Bei der Konfiguration des Azure Data Lake Store-Kontos in SnapLogic (siehe unten) werden die Azure Tenant ID, Access ID und der geheime Schlüssel verwendet, die Sie über das Azure-Portal erhalten:

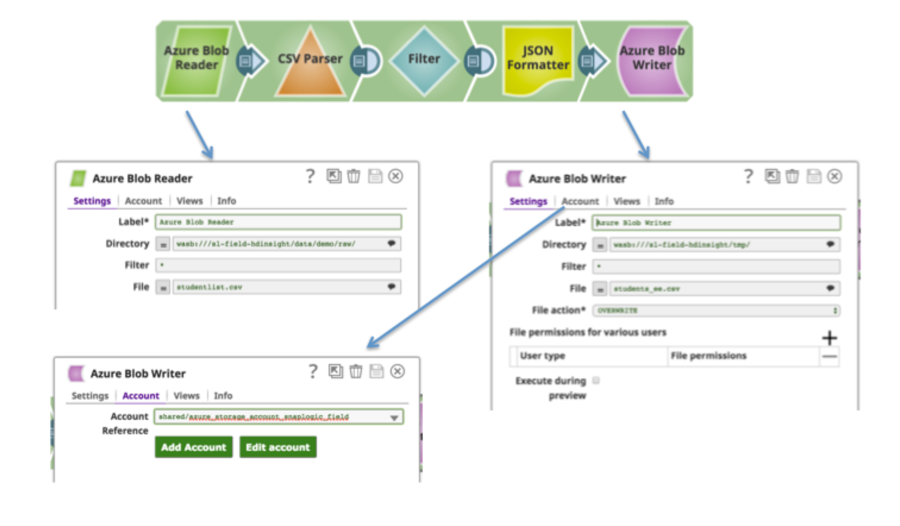

Zusammengenommen haben Sie eine einfache Pipeline, die veranschaulicht, wie man in Azure Blob Storage liest und schreibt:

Hier ist noch einmal das Schritt-für-Schritt-Video: Aufbau einer einfachen Pipeline zum Lesen und Schreiben von Daten in Azure BLOG-Speicher

In meinem nächsten Blog-Beitrag werde ich beschreiben, wie Sie Daten von Ihren On-Prem-Datenbanken zu Azure SQL Database verschieben können .

Prasad Kona ist ein Unternehmensarchitekt bei SnapLogic. Sie können ihm folgen auf LinkedIn oder Twitter @prasadkona.