Das Webinar dieses Monats drehte sich um große Daten und wie Kunden die SnapLogic Elastic Integration Platform nutzen können und SnapReduce 2.0. In der gestrigen Live-Diskussion und Demonstration sprachen wir mit SnapLogic-Chefwissenschaftler Greg BensonEr ist Professor für Informatik an der Universität von San Francisco und forscht seit mehr als 20 Jahren in den Bereichen verteilte Systeme, parallele Programmierung, Betriebssystemkerne und Programmiersprachen. Das Webinar ging auf die Details von SnapReduce 2.0 für die Big-Data-Integration ein (mehr dazu später), aber zunächst sprachen wir über Hadoop in Bezug auf die bisherige Entwicklung, die Zukunft und die Auswirkungen auf das traditionelle Data Warehousing in Unternehmen. Im Folgenden finden Sie eine kurze Zusammenfassung:

Das Webinar dieses Monats drehte sich um große Daten und wie Kunden die SnapLogic Elastic Integration Platform nutzen können und SnapReduce 2.0. In der gestrigen Live-Diskussion und Demonstration sprachen wir mit SnapLogic-Chefwissenschaftler Greg BensonEr ist Professor für Informatik an der Universität von San Francisco und forscht seit mehr als 20 Jahren in den Bereichen verteilte Systeme, parallele Programmierung, Betriebssystemkerne und Programmiersprachen. Das Webinar ging auf die Details von SnapReduce 2.0 für die Big-Data-Integration ein (mehr dazu später), aber zunächst sprachen wir über Hadoop in Bezug auf die bisherige Entwicklung, die Zukunft und die Auswirkungen auf das traditionelle Data Warehousing in Unternehmen. Im Folgenden finden Sie eine kurze Zusammenfassung:

- Die Reise zu Big Data: Greg sprach über frühe Initiativen und Anwendungsfälle und darüber, dass so viele "Datenabfälle" auf dem Boden liegen blieben.

- Hadoop und Data Warehousing: Viele sind der Meinung, dass Hadoop und das Hadoop-Ökosystem aufgrund der Wirtschaftlichkeit von Hadoop und der neuen Möglichkeiten der Datenspeicherung die heutigen relationalen Data-Warehouses irgendwann ersetzen werden. Im Moment ergänzen sie sich jedoch noch.

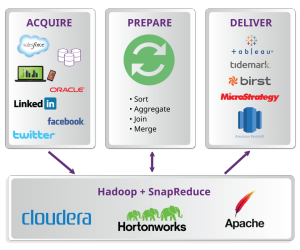

- Auswirkungen auf die Datenintegration: Es gab eine gute Diskussion darüber, warum alte Technik in der neuen Ära von SMAC nicht mehr funktioniert, und über die Vielfalt der Quellen und Anwendungsfälle für die Streaming- und Batch-Datenverarbeitung.

- Die Notwendigkeit, Big Data zu erfassen, aufzubereiten und bereitzustellen: Dies umfasst sowohl die Batch- als auch die Streaming-Verarbeitung für eine neue Generation von ETL/ELT.

Im Anschluss an die Diskussion über Big Data gingen Greg und das Team auf SnapReduce 2.0 und das Konzept der elastischen Skalierung ein und beantworteten in einer Fragerunde die Fragen von Kunden und Interessenten. Sehen Sie sich die Präsentationsfolien und Fragen unten an:

Wie lässt sich SnapLogic über zwei Clouds hinweg einsetzen, z. B. Salesforce in einer Cloud und soziale Daten in einer anderen Cloud?

Das erste, was man verstehen muss, ist, dass SnapLogic Snaplex die Schwerkraft der Daten respektiert. Aus dieser Frage geht hervor, dass "Dienste" als separate Clouds betrachtet werden. SnapLogic verbindet auf einfache Weise getrennte Dienste und Anwendungen und kann dies entweder in unserer Cloud oder über einen Snaplex, der vor Ort oder in einer VPC läuft, tun. Wie wir im Webinar beschrieben haben, kann der Snaplex mit SnapReduce jetzt auch nativ als YARN-Anwendung innerhalb eines Hadoop-Clusters laufen.

Ist es möglich, Daten zu transformieren, bevor sie in das HDFS geschrieben werden?

Ja, absolut. Beim Streaming von Daten in HDFS können die Daten gefiltert oder transformiert werden, bevor sie in HDFS geschrieben werden.

Werden die Datenströme (Pipelines) in Jar-Dateien oder etwas wie Pig konvertiert?

MapReduce Ode wird direkt generiert und als Jar-Datei an Hadoop ausgegeben.

Kann SnapLogic direkt eine .tde-Datei für Tableau schreiben oder handelt es sich um eine CSV-Datei, die Tableau später in sein natives Format konvertiert?

Der SnapLogic Tableau Snap schreibt direkt in eine TDE-Datei.

Könnte ich nach dem Lesen von Daten aus dem HDFS mit dem HDFS Reader eine Verknüpfung mit Daten in einer Quelle/Datenbank (z. B. Oracle/SQL Server) vornehmen?) Wenn ja, wo wird diese Pipeline verlaufen?

Ja, das ist möglich, und in diesem Szenario würde die Pipeline in Hadoop laufen, aber auf einem einzigen Hadoop-Knoten. Sie würde nicht als MapReduce-Auftrag ausgeführt werden.