"Questo non è l'ETL di vostro padre. Non è il message bus di vostra madre. Non è l'integrazione di applicazioni di vostro zio".

- Rich Dill commenta la necessità di pensare in modo diverso all'integrazione di applicazioni e dati con SnapLogic

Questa settimana ho incontrato Rich Dill, uno dei guru dell'integrazione dei dati di SnapLogic, con oltre vent'anni di esperienza nel mondo della gestione dei dati e del data warehousing. Rich ha parlato del salto di qualità in termini di facilità d'uso e di abilitazione degli utenti che una piattaforma di integrazione come servizio (iPaaS) può fornire. Ha anche commentato le differenze di latenza e quando si tratta di spostare i dati da un cloud a un altro o da un cloud a un data center, rispetto allo spostamento dei dati da un'applicazione a un data warehouse in un data center.

Questa settimana ho incontrato Rich Dill, uno dei guru dell'integrazione dei dati di SnapLogic, con oltre vent'anni di esperienza nel mondo della gestione dei dati e del data warehousing. Rich ha parlato del salto di qualità in termini di facilità d'uso e di abilitazione degli utenti che una piattaforma di integrazione come servizio (iPaaS) può fornire. Ha anche commentato le differenze di latenza e quando si tratta di spostare i dati da un cloud a un altro o da un cloud a un data center, rispetto allo spostamento dei dati da un'applicazione a un data warehouse in un data center.

"Quando si utilizza una nuova tecnologia, le persone tendono a usare i vecchi approcci. E senza formazione non sono in grado di sfruttare le caratteristiche e le capacità della nuova tecnologia. È il vecchio adagio del mettere il piolo quadrato in un buco rotondo".

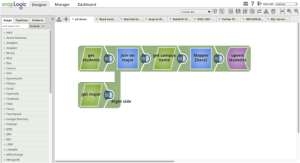

Per evidenziare la potenza di SnapLogic, che riunisce diversi stili di integrazione in un'unica piattaforma, Rich ha realizzato questa dimostrazione, in cui crea un flusso di dati, chiamato pipeline, che si concentra su un caso d'uso classico di estrazione, trasformazione e caricamento (ETL), ma che va ben oltre. Ecco una sintesi di SnapLogic che consuma, trasforma e distribuisce i dati.

Parte 1: ETL come servizio

- Rich seleziona i dati da due database, spiegando come sia possibile visualizzare i dati in anteprima e in più formati mentre scorrono nella piattaforma.

- Il relatore esamina come SnapLogic elabora i documenti JSON, che danno alla piattaforma la possibilità di accoppiare in modo lasco la struttura del lavoro di integrazione al target, e prosegue con l'esecuzione di join interni ed esterni prima di formattare l'output e scrivere i dati uniti su un file writer.

- Poi torna indietro e aggiunge un SQL Server Lookup per ottenere ulteriori informazioni.

- Esegue la pipeline e ne crea una versione.

Parte 2: Gestione del cambiamento (Vi è mai capitato di dover aggiungere qualche colonna in più in un database e di dover poi modificare la vostra attività di integrazione dei dati?)

- Entra e modifica la tabella SQL sottostante.

- Esegue nuovamente la pipeline SnapLogic e mostra i nuovi risultati, senza dover apportare alcuna modifica. Questo evidenzia la flessibilità e l'adattabilità di SnapLogic Elastic Integration Platform.

Parte 3: Caricamento dei dati di Salesforce

- Il nostro esperto ha introdotto il Data Mapper Snap per mappare i dati in Salesforce.

- Trascina e rilascia lo snap Upsert di Salesforce e determina se utilizzare l'API REST o Bulk.

- Utilizza SmartLink per eseguire una ricerca fuzzy e mappare i campi di ingresso e di uscita.

- Esamina l'Expression Editor per evidenziare i tipi di trasformazione dei dati possibili.

- Mostra come i dati vengono inseriti in Salesforce e salva questa versione della pipeline.

Parte 4: Pipeline RESTful

- Rimuove il Data Mapper Snap, perché l'output sarà diverso, e inserisce il JSON Formatter.

- Qui, Rich dedica un minuto a esaminare come SnapLogic non solo sia un modello documentale ad accoppiamento libero, ma sia anche basato al 100% su REST. Ciò significa che ogni pipeline è astratta e, come dice lui, "indirizzabile, utilizzabile, consumabile, attivabile e programmabile come una chiamata REST".

- Va in Gestione > Attività, crea una nuova attività e la imposta su Attivazione.

- Esegue il task per dimostrare che, chiamando la pipeline basata su REST, può mostrare come un dispositivo mobile possa eseguire un Get REST per portare i dati in un dispositivo mobile.

- Conclude la dimostrazione cambiando la pipeline da un documento JSON a un documento XML.

Ho incorporato il video qui sotto. Per altre informazioni sulla piattaforma di integrazione elastica di SnapLogic, consultate il nostro centro risorse. Grazie per l'ottima dimostrazione Rich!