Nel post precedente abbiamo parlato di ciò che SnapLogic Hadooplex può offrire con Spark. Ora continuiamo la conversazione vedendo quali sono gli Snap disponibili per costruire pipeline Spark.

La suite di Snaps disponibile in modalità Spark ci permette di ingerire e atterrare i dati da un ecosistema Hadoop e di trasformarli sfruttando le operazioni parallele come map, filter, reduce o join su un Resilient Distributed Datasets (RDD), che è una raccolta di elementi fault-tolerant su cui si può operare in parallelo.

Esistono vari formati disponibili per l'archiviazione dei dati in HDFS. Questi formati di file supportano uno o più formati di compressione che influiscono sulla dimensione dei dati memorizzati nel file system HDFS. La scelta dei formati di file e della compressione dipende da vari fattori, come le prestazioni desiderate per un caso d'uso specifico di lettura o scrittura, il livello di compressione desiderato per l'archiviazione dei dati.

Gli snap disponibili per l'ingestione e l'atterraggio dei dati nella pipeline Spark sono HDFS Writer, Parquet Writer, HDFS Reader, Sequence Parser, Parquet Reader e Sequence Formatter.

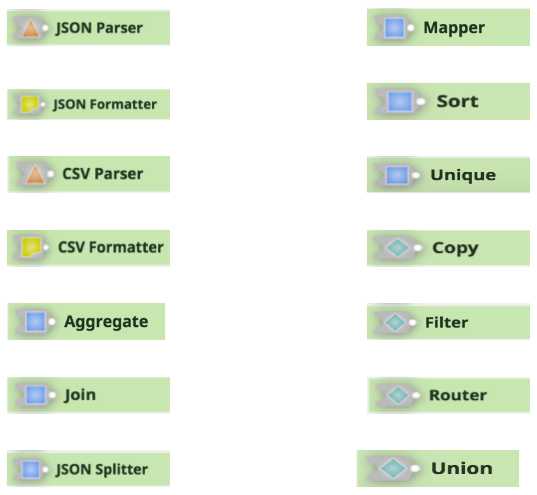

Gli altri snap della pipeline di Spark per supportare la trasformazione e il flusso dei dati sono JSON Parser, Mapper, JSON Formatter, Sort, CSV Parser, Unique, CSV Formatter, Copy, Aggregate, Filter, Join, Router, JSON Splitter e Union.

È possibile scoprire come costruire ed eseguire pipeline Spark per HDInsight, guardare una demo di SnapLogic Spark o contattarci per ulteriori informazioni sulle soluzioni di integrazione dei big data Spark di SnapLogic.